クアルコムがAIチップ市場に本格参入? クアルコムのAIチップの将来性は?

モバイルの雄が新たな「AIインフラ」へ

スマートフォン用のモバイル SoC(System on a Chip)〜モデムチップの分野で圧倒的な存在感を持つ Qualcomm。長年にわたり、同社の「Snapdragon」シリーズなどはモバイル/PC/エッジデバイス向けに広く採用されてきました。 オリックス・レンテック+2ケータイ Watch+2

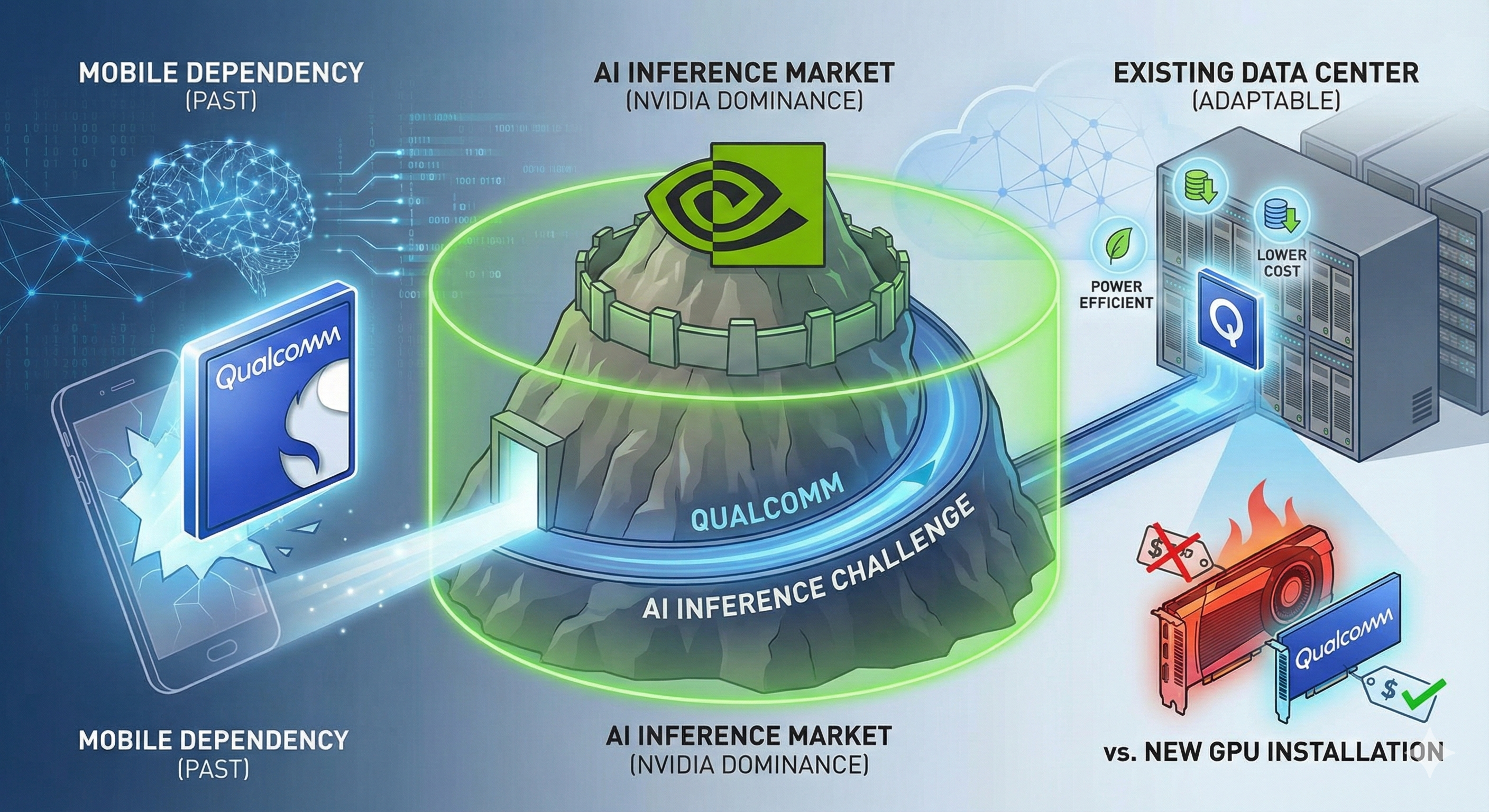

しかし、近年の AI ブーム、特に大規模言語モデル(LLM)や生成 AI の普及に伴い、“AI 推論(inference)やデータセンター向け AI インフラ” の需要が急激に高まっています。この環境の変化を背景に、Qualcomm は 2025年10月に データセンター向け AI チップ「Qualcomm AI200」および「Qualcomm AI250」 を発表。AI チップ市場—特に GPU / AI アクセラレータが席巻するデータセンター市場—への本格参入を宣言しました。 Investing.com+2ケータイ Watch+2

本記事では、なぜ Qualcomm が今 “AI チップ市場” に乗り出すのか、その狙いと可能性、そしてリスクを含め、2025年現在判明している情報をもとに整理・分析します。

クアルコムが AI チップ市場に本格参入?

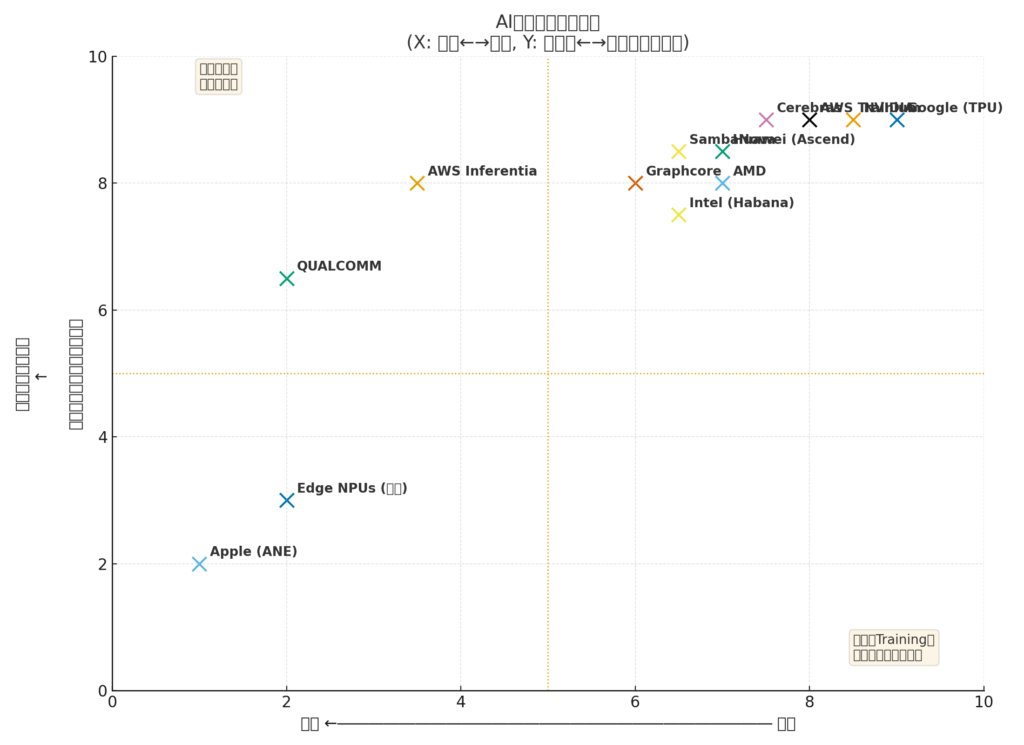

マップの読み方(簡単解説)

- X軸:左が「推論(Inference)重視」、右が「学習(Training)重視」

- Y軸:下が「エッジ(小規模・端末寄り)」、上が「データセンター(大規模)」

- 配置は2025年時点の一般的な市場ポジションの概観です(概ねの位置づけであり、各社の製品ラインによって内部差があります)。

主な配置の意図(例)

- NVIDIA / Google(TPU) / AWS Trainium:学習重視かつデータセンター向け(右上)

- Qualcomm:推論重視だがエッジ〜データセンターの中間〜上位を狙う(左寄り〜中上)

- Apple ANE:完全にエッジ(端末)寄りの推論特化(左下)

- AWS Inferentia:推論向けでデータセンター導入が主(左上)

- Graphcore / Cerebras / Intel(Habana) / AMD / Huawei / SambaNova:それぞれ学習〜推論、データセンター〜エッジの幅で分布

新発表:AI200 / AI250 — データセンター向け AI 推論アクセラレータ

2025年10月27日、Qualcomm はデータセンター向けの新 AI チップとして「AI200」と「AI250」を発表しました。これにより、同社は従来のモバイル/PC/エッジ市場だけでなく、クラウドや大規模データセンターを含む AI インフラ市場に正式に参入します。 GuruFocus+3Investing.com+3ケータイ Watch+3

- AI200:最初の世代で、2026年に商用提供を予定。単体カードとして、あるいはフルラック(サーバーラック)として導入可能。メモリ容量や帯域幅、消費電力効率に重きを置いた設計。 ケータイ Watch+2AOL+2

- AI250:次世代モデルで、2027年ごろの商用化を予定。より高帯域なメモリアーキテクチャ(ニアメモリー・コンピューティングなど)を導入し、推論処理をさらに効率化。 ケータイ Watch+2GuruFocus+2

この発表を受け、株価は急騰。市場は Qualcomm の AI シフトを歓迎する姿勢を見せています。 Investing.com+2AOL+2

背景にある変化と戦略

なぜ今、Qualcomm は AI チップ市場に本格参入するのか。主な理由・背景は以下の通りです。

- スマートフォン市場の飽和と成長鈍化

モバイル市場は成熟を迎えており、これまでのような爆発的な成長は見込みにくい。一方で、AI やクラウド、データセンターに対する需要が急拡大。Qualcomm にとって、新たな成長ドライバーが必要となっていた。 GuruFocus+2Los Angeles Times+2 - モバイルで培ってきた NPU / SoC 技術の“スケールアップ”への応用

Qualcomm はモバイル向け SoC において、CPU/GPU/NPU(Neural Processing Unit)などの集積による高い省電力と効率性を実現してきた。今回の AI200/AI250 は、こうした NPU の技術資産を、データセンター向けに拡張する試みと位置づけられている。 Los Angeles Times+2moneycontrol.com+2 - AI インフラ需要の急増

生成 AI、LLM、マルチモーダル AI の普及に伴って、クラウド・データセンター、クラウドサービス事業者、企業の内部インフラなどで大量の推論処理能力が求められるようになっている。この潮流に乗ることで、新たな収益源を確保できる可能性。 Investing.com+2GuruFocus+2

このように、タイミングと戦略が合致したことで、Qualcomm は“モバイル中心”から“AIインフラも含む総合半導体ベンダー”へと進化を図っているのです。

クアルコムのAIチップの将来性は?

エネルギー効率とコストに強み — 新たな価値提案

AI200 / AI250 の発表資料や報道では、Qualcomm は“消費電力あたりの推論効率”“高いメモリ容量と帯域”“柔軟な導入形態(カード単体/ラック単位)”を強調しています。 ケータイ Watch+2Investing.com+2

特に、データセンター運営においては電力コストや冷却コストが大きなファクターとなるため、推論効率の高さ/省電力性能 は大きなアドバンテージ。もし実際のパフォーマンスが公称に近ければ、コスト重視のクラウド事業者や企業ユーザーにとって魅力的な選択肢となる可能性があります。

また、カード単体の利用だけでなく、ラック単位での導入も可能とされており、既存のサーバーに柔軟に組み込める点も “既存インフラの流用”“導入コストの抑制” という点で有利。これにより、大規模データセンターだけでなく、比較的小規模の企業やエッジクラウド、オンプレミス用途までカバーする可能性があります。

市場の追い風 — AI 推論需要の拡大

生成 AI、LLM、マルチモーダルモデルの普及により、AI の使用用途は拡大の一途をたどっています。チャットボット、画像生成、文書生成、音声/映像認識、推論型 AI サービスなど、多様な需要が生まれており、これらを支える「AI インフラ」の需要は今後も拡大が見込まれます。

Qualcomm が提供するような、効率性とコストを重視した AI 推論基盤 は、この流れにマッチする可能性が高く、特にコスト敏感な事業者・サービスによる採用拡大が期待されます。

モバイル〜PC〜クラウドまでのシームレス展開 — エコシステムの強み

Qualcomm はこれまでモバイルや PC(エッジ)向けに強みを持っていました。そして 2024〜2025年にかけては、PC 向け Snapdragon チップ(たとえば「Snapdragon X Elite/X Plus/X」など)が拡充されており、エッジコンピューティングでの AI 利用も視野に入れた展開をしています。 ケータイ Watch+2ITmedia+2

この流れを補完する形で、クラウド/データセンター向け AI チップも提供開始すれば、モバイル → エッジ → クラウドまでをカバーできる「ワンストップ AI プラットフォーム」の構築が可能となります。これは技術統合、運用効率、ソフトウェアスタックの統一など多くの面でメリットがあるため、長期的な優位性になり得ます。

クアルコムのAIチップは推論向けでエヌビディアと別市場?

推論重視 ―「Training ではなく Inference」が基本

Qualcomm が発表した AI200/AI250 は、「AI 推論(inference)」用途に最適化されたアクセラレータであることが明らかにされています。すなわち、既に学習済みのモデルを動かすフェーズでの高速処理、低電力/低コスト運用を目的としており、「学習(training)」向けの重い GPU ワークロードを必ずしもターゲットとしているわけではありません。 ケータイ Watch+2Investing.com+2

この点で、これまで AI インフラ市場の中核を担ってきた NVIDIA の GPU(GPU を用いた学習および推論)とは、必ずしも完全な競合ではない可能性があります。NVIDIA の強みは「大規模モデルのトレーニング」や「多用途 GPU」にあるのに対し、Qualcomm は「効率重視の推論基盤」を前面に打ち出しているためです。

“別市場”としてのポジショニング — 補完関係の可能性

実際、ある種のクラウド事業者やサービス提供者は、モデルの学習は GPU/TPU で行い、推論は低コストで省電力なアクセラレータで実行したい、という構成を望むケースがあります。特に、リアルタイム応答が必要なチャットボットやマルチモーダル処理、企業内の AI サービスなどでは、「推論の効率とコスト」が重要です。

このような用途では、Qualcomm の AI200/AI250 のような “推論専用アクセラレータ” は、NVIDIA に代わる 補完的 または 代替的 選択肢となりうる。つまり、両者は完全な奪い合いの関係ではなく、用途や目的によって使い分けられる別市場を形成する可能性があります。

ただし、今後のソフトウェア対応、エコシステム、互換性、普及状況によっては競合関係が強まる可能性もあるため、動向を注視する必要があります。

クアルコムのAIチップは AI データセンターにも挑む?

フルラック/サーバー規模での提供 — データセンター用途を見据えた設計

Qualcomm の発表によれば、AI200/AI250 は単体のアクセラレータカードとしてだけでなく、「ラック(サーバーラック)スケール」での導入にも対応する設計です。つまり、クラウド事業者や大規模データセンター向けに、既存のシステムに組み込む形で導入できる柔軟性があります。 AOL+2Los Angeles Times+2

このような提供形態は、「単にチップを売る」のではなく、「データセンター向けインフラを売る」という意味を含んでおり、Qualcomm が本格的にデータセンター市場を狙っていることの証左といえます。

流通環境と市場の受け入れ — タイミングとニーズ次第

AI インフラ市場には既に多くの GPU ベンダー、アクセラレータベンダー、クラウド事業者、AI スタートアップがひしめいており、競争は激しい。ただし、次のような条件が整えば、Qualcomm にとって大きなチャンスがあります:

- 電力コストや運用コストを重視するクラウド/オンプレミス需要があること

- 低遅延、高効率な推論を求めるアプリケーション(チャットボット、リアルタイム AI、エンタープライズ AI など)が普及すること

- 推論用ハードウェアにおける多様性と選択肢を求める企業が増えること

もしこれらのニーズが現実化すれば、Qualcomm の AI チップは “NVIDIA/AMD 以外の現実的選択肢” として普及の余地があります。

また、モバイル/エッジ〜クラウドという一貫したエコシステムを持つ Qualcomm だからこそ、エッジで動く AI アプリからクラウドまでをひとまとめにできる “トータルソリューション” を提供できる点も強みと言えるでしょう。

クアルコムのAIチップはスマホ依存から脱却中?

多角化戦略 — モバイル一辺倒からの脱却

これまで Qualcomm の収益の多くはスマートフォン向けチップ(Snapdragon など)およびモデム、通信関連に依存していました。 オリックス・レンテック+1

しかし、スマホ市場の成熟や競争激化、価格競争などにより、モバイルだけに依存するリスクが増大。一方で、PC/エッジ/AI/クラウドなど新たな市場が拡大していることを受け、Qualcomm は自社のビジネスモデルを多角化させています。例えば、PC 向け Snapdragon の強化、AI 推論向けチップの参入、さらにはクラウド/データセンター市場への進出などです。 ケータイ Watch+2ITmedia+2

このようなシフトは、スマホ依存からの脱却という意味で戦略的な転換を示しています。

将来的な安定性とポートフォリオの拡張

AI チップ市場、特にデータセンター向けインフラ市場は、今後数年〜十年にわたって成長が期待されています。もし Qualcomm がここで基盤を築ければ、スマホやモバイル市場の景気変動に左右されにくい、より安定性の高い収益ポートフォリオを構築できる可能性があります。

また、モバイル → エッジ → クラウド という “三層構造” をカバーすることで、AI のユースケースの広がりに柔軟に対応できる企業としての地位を確立できるかもしれません。

課題と留意点 — 乗り越えるべきハードル

もちろん、Qualcomm の AI チップ参入には期待だけでなく、いくつかの課題やリスクも存在します。

- 実際の性能とエコシステムの成熟

発表時点では、AI200/AI250 の性能や効率、安定性は“設計上の目標”であり、実運用でどの程度その性能が出せるかはこれから検証が必要。特にソフトウェア対応、フレームワークの最適化、運用環境での安定動作などが重要。 - ソフトウェア互換性・既存の AI エコシステムとの競合

多くの AI モデルやライブラリは現在 GPU(特に NVIDIA)を前提として設計されているため、新しいハードウェアでの互換性、最適化が進まなければ、導入障壁が高い。 - 市場での信頼性・採用実績の不足

NVIDIA やその他の既存ベンダーに比べ、Qualcomm の AI チップは新参。企業やクラウド事業者が大規模導入を決めるには、“安定性”“サポート”“実績” が重要であり、これらを積み上げるまでには時間がかかる可能性がある。 - 競合の激化

AI インフラ市場は現在、GPU ベンダー、アクセラレータベンダー、さらに CPU ベンダー、クラウド独自チップ開発企業など、多数のプレイヤーがひしめいており、競争は激しい。Qualcomm が勝ち残るには、技術・価格・信頼性・エコシステムの総合力が問われる。

これらを踏まえ、Qualcomm の AI チップが“次のインフラ標準”となるかどうかは、今後の動向次第といえます。

まとめ:クアルコムの AI 戦略は「本物」の挑戦か — 中長期で注目

Qualcomm の AI200 / AI250 によるデータセンター市場参入は、単なる「話題作り」ではなく、モバイル中心から AI インフラまでを視野に入れた真剣なビジネス戦略です。

- モバイル市場の成長鈍化を背景に、スマホ依存からの脱却を図る

- モバイル/PC/エッジ/クラウドをまたぐ「統合的な AI プラットフォーム」の構築を目指す

- 推論に特化した効率的な AI チップで、コストと電力に敏感なデータセンターやクラウド需要に応える

この戦略が成功すれば、Qualcomm は単なるモバイル半導体ベンダーの枠を超え、“AI 時代のインフラ企業”としての地位を築く可能性があります。

しかし、実運用での性能、エコシステムの成熟、ソフトウェアの最適化、そして市場での信頼性獲得といったハードルも多く、楽観はできません。特に、既存の GPU/アクセラレータ市場で確立された地位を揺るがすには、相応の実力と時間が必要でしょう。

――とはいえ、今後 2〜3 年の動きは非常に重要で、AI インフラの勢力図を大きく塗り替える可能性を持つ「注目すべき賭け」であることは間違いありません。